Le piattaforme tecnologiche non stanno mantenendo la promessa di etichettare i contenuti generati con l’IA

Una verifica condotta da Indicator su centinaia di immagini e video generati con IA rivela che le piattaforme spesso non etichettano questi contenuti

Negli ultimi due anni, le principali aziende tecnologiche hanno promesso di aiutare gli utenti a identificare i contenuti generati con intelligenza artificiale aggiungendo etichette alle immagini e ai video creati con questa tecnologia.

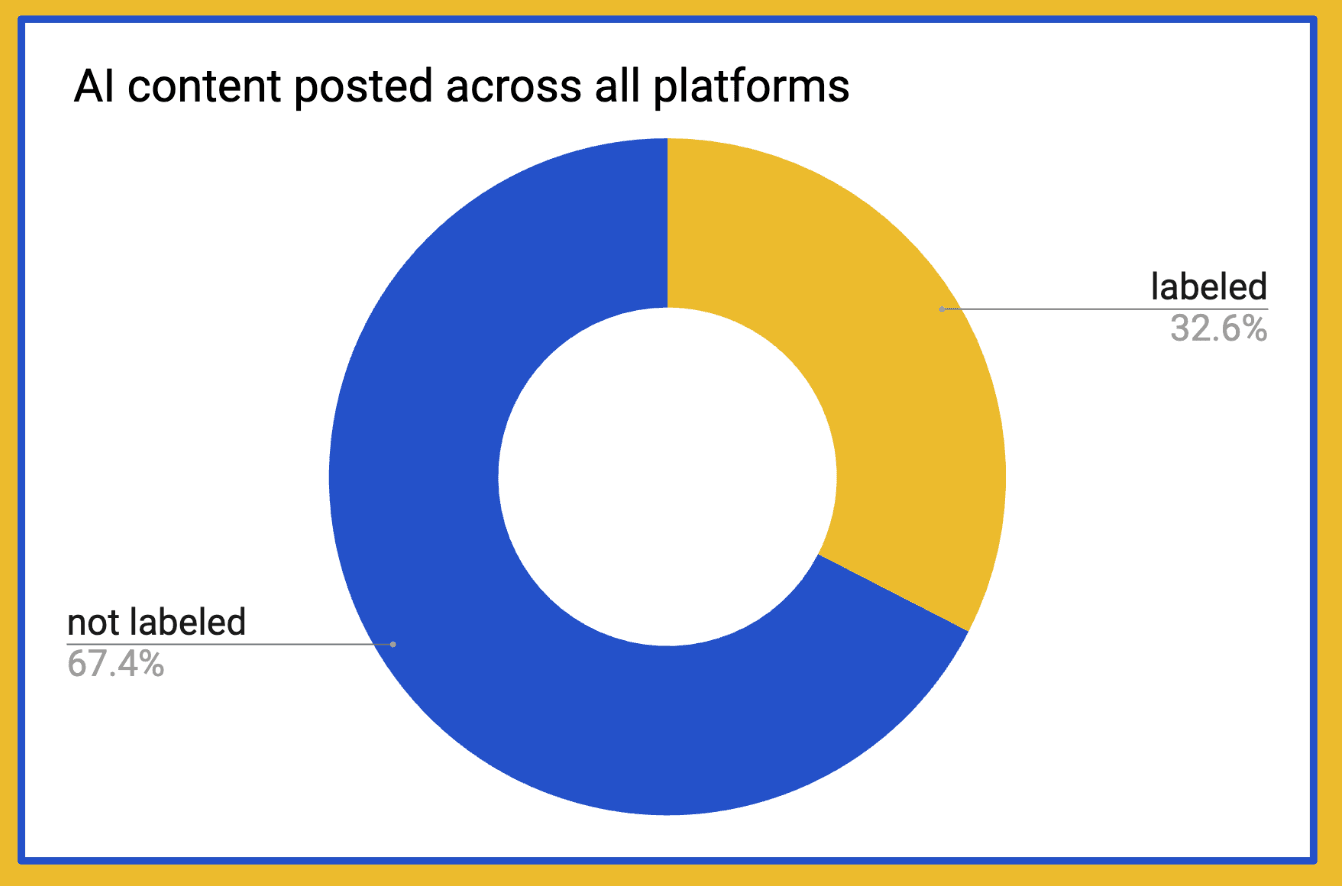

Tuttavia, una verifica condotta da Indicator ha rivelato che cinque grandi piattaforme con miliardi di utenti hanno ripetutamente omesso di etichettare i contenuti generati con l’intelligenza artificiale. Nel corso di tre settimane, Indicator ha pubblicato 516 post contenenti immagini e video IA su Instagram, LinkedIn, Pinterest, TikTok e YouTube. Solo 169 post, ovvero poco più del 30 per cento del totale, sono stati correttamente etichettati come generati dall’intelligenza artificiale.

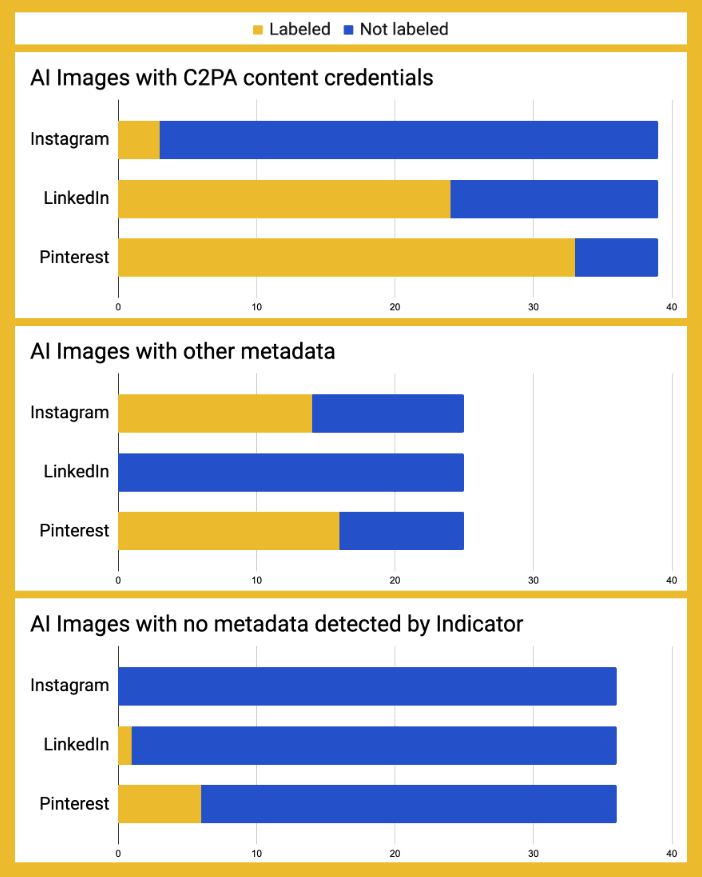

Abbiamo scoperto che alcune piattaforme, come Google e Meta, hanno ripetutamente omesso di etichettare i contenuti generati con i loro strumenti di IA generativa. TikTok ha etichettato i contenuti artificiali creati utilizzando il proprio strumento generativo presente nell’applicazione, ma non ha aggiunto alcuna etichetta ad altri video generati con IA. Pinterest è stato il più efficace nell’etichettare le immagini generate con IA, anche se la sua percentuale di successo è stata solo del 55 per cento.

I risultati sollevano serie preoccupazioni circa l’attuazione da parte delle grandi aziende tecnologiche di sforzi concreti volti ad aiutare gli utenti a orientarsi nel moderno panorama informativo.

«Questa indagine dimostra che abbiamo bisogno di una verifica rigorosa, per garantire che vere risorse, e con un certo grado di urgenza, siano applicate all’etichettatura dell’IA», sottolinea Claire Leibowicz, direttrice di IA, Trust and Society presso la Partnership on AI. Leibowicz ha poi aggiunto: «Se esistono veri e propri ostacoli tecnici che rendono questo compito più difficile del previsto, abbiamo bisogno che le aziende li rendano noti, affinché tutti possano contribuire a risolverli in modo collaborativo. Non abbiamo bisogno, invece, che le aziende usino la complessità come scudo per l’inazione, né che esagerino le proprie funzionalità».

Secondo Sam Gregory, direttore esecutivo dell’organizzazione per i diritti umani Witness, «non si tratta solo di identificare singoli deepfake che potrebbero essere ingannevoli o dannosi, ma dell’erosione della fiducia nella verità visiva stessa. I dirigenti delle aziende tecnologiche non stanno prendendo sul serio né l’impatto sistemico della corrosione della nostra capacità di distinguere l’autentico dall’artificiale né la necessità di lavorare insieme per contrastare questa minaccia epistemica».

I risultati della verifica di Indicator suggeriscono che la trasparenza sulla presenza di contenuti generati con IA «non è la massima priorità per le piattaforme». Questa è l’opinione di Hany Farid, professore alla Information School della UC Berkeley e co-fondatore della società di rilevamento dii deepfake GetReal Security.

I rappresentanti di Meta, Pinterest e TikTok hanno rifiutato di commentare ufficialmente su questa analisi, ma hanno fornito informazioni di contesto. Le aziende non hanno contestato i risultati di Indicator, e hanno affermato che l’etichettatura dei contenuti generati con IA è un processo sul quale stanno lavorando e che migliorerà nel tempo. Google, LinkedIn e OpenAI non hanno risposto alle numerose richieste di commento.

Claire Wardle, professoressa associata di comunicazione alla Cornell University (dove lavora anche il co-autore della newsletter, Alexios Mantzarlis), ha affermato che l’analisi di Indicator rivela un «malfunzionamento intra-piattaforme» nell’implementazione delle etichette IA. Ciò significa che i ricercatori e le autorità di regolamentazione devono «essere coerenti con verifiche regolari e non possono semplicemente dare per scontato che, poiché qualcosa è stato lanciato, funzioni», secondo Wardle.

Un elemento centrale dell’ecosistema di etichettatura è la Coalizione intersettoriale per la provenienza e l’autenticità dei contenuti (C2PA), che coordina lo sviluppo e l’implementazione dello standard C2PA. Andy Parsons, direttore senior per l’autenticità dei contenuti presso Adobe e forza trainante della C2PA, ha riconosciuto che «il modo in cui questi dati vengono mostrati sulle piattaforme è incoerente. Sebbene molte piattaforme processino i dati C2PA, questi vengono talvolta utilizzati per scopi interni e non vengono mostrati agli utenti. Ci aspettiamo che la quantità di dati mostrati aumenterà nei prossimi mesi».

L’etichettatura affidabile e precisa dei contenuti generati con IA è una sfida socio-tecnica complessa che coinvolge molteplici attori. Non sorprende che incontri alcuni ostacoli. Tuttavia, è essenziale che questi meccanismi funzionino come previsto e che vengano verificati i progressi (o la mancanza di essi) delle promesse fatte più di un anno fa da alcune delle aziende più potenti al mondo.

Lo stato attuale dell’etichettatura dei contenuti generati con IA potrebbe riflettere i limiti di un approccio di autoregolamentazione. La situazione cambierà nell’estate del 2026, quando entreranno in vigore in California e nell’Unione europea le normative che includono i requisiti relativi all’etichettatura.

Promesse delle piattaforme e requisiti normativi

L’etichettatura dei contenuti generati dall’IA coinvolge tre attori chiave: le aziende che gestiscono strumenti di IA generativa, le piattaforme social su cui vengono pubblicati i contenuti generati con l’IA e i gruppi industriali come il C2PA che contribuiscono a stabilire standard per l’etichettatura dei contenuti artificiali.

Adobe, Google, Meta e OpenAI si sono pubblicamente impegnate ad aggiungere ai contenuti generati con i loro software IA filigrane che siano leggibili dai computer.

Molte delle più grandi piattaforme social hanno dichiarato che applicheranno etichette ai contenuti generati con l’IA, anche se, come documentato dalla guida alle etichettatura di contenuti IA pubblicata su Indicator, le implementazioni variano. Instagram «potrebbe» identificare ed etichettare «i contenuti con segnali che possono essere identificati come creati con l’IA», inclusi «tutti i contenuti creati o modificati utilizzando gli strumenti di IA di Meta e condivisi su Facebook, Instagram o Threads». LinkedIn ha annunciato un anno fa che avrebbe «adottato lo standard C2PA».Pinterest afferma che «non solo analizziamo i metadati di un’immagine seguendo lo standard IPTC Metadata Standard, ma abbiamo anche sviluppato classificatori che rilevano automaticamente i contenuti Gen AI, anche se questi non presentano filigrane evidenti». TikTok «potrebbe applicare automaticamente l’etichetta “generato con l’IA” ai contenuti che identifichiamo come completamente generati o significativamente modificati con l’IA. Ciò può accadere quando un content creator […] carica contenuti generati con l’IA a cui sono allegate Content Credentials (credenziali di contenuto, ndr)». YouTube «riporterà le informazioni fornite dagli strumenti e dai content creator disponibili con credenziali di contenuto sicure (Content Credentials C2PA 2.1 o versioni successive) che indicano che l’intero video è stato realizzato con l’IA».

Molte delle piattaforme che abbiamo esaminato supportano le pratiche responsabili della Partnership on AI per i contenuti generati con intelligenza artificiale, che includono le migliori pratiche per la divulgazione dell’uso di contenuti artificiali. Fanno tutte parte della C2PA e hanno sottoscritto l’impegno a utilizzare le sue Content Credentials come standard.

L’autoregolamentazione del settore non è l’unico motore del cambiamento. L’AI Act dell’Unione europea, infatti, richiede alle aziende che forniscono strumenti di IA generativa per uso generico di apporre un watermark agli output dei propri modelli. L’AI Transparency Act della California, invece, da un lato impone alle aziende di IA generativa di offrire strumenti gratuiti per rilevare l’autenticità di un contenuto, e dall’altro obbliga le grandi piattaforme online a eseguire la scansione dei metadati che indicano se un contenuto è stato generato dall’IA. Queste leggi entreranno in vigore il prossimo anno. La Cina, nel frattempo, è più avanti, avendo recentemente iniziato ad applicare la propria legge sui metadati e l’etichettatura dei contenuti generati con IA.

David Evan Harris, ricercatore presso UC Berkeley, che ha partecipato agli sforzi normativi della California e dell’UE, afferma che tali leggi stabiliscono «una nuova norma» in base alla quale gli utenti «cominciano ad aspettarsi di poter verificare la provenienza dei contenuti che vedono online».

Cosa abbiamo fatto

Abbiamo generato con l’intelligenza artificiale un insieme di immagini e video fotorealistici e non fotorealistici. Lo abbiamo fatto utilizzando strumenti di proprietà di aziende che hanno aderito al comitato direttivo C2PA e che si sono impegnate a incorporare metadati nell’output dei loro modelli.

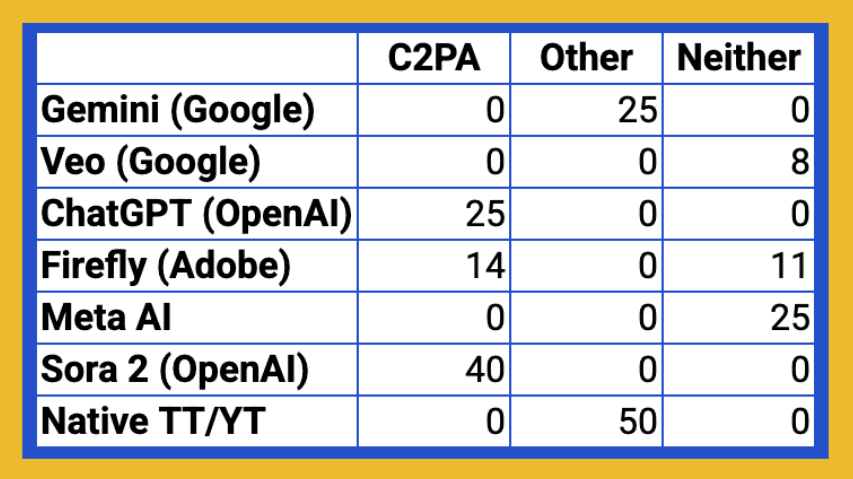

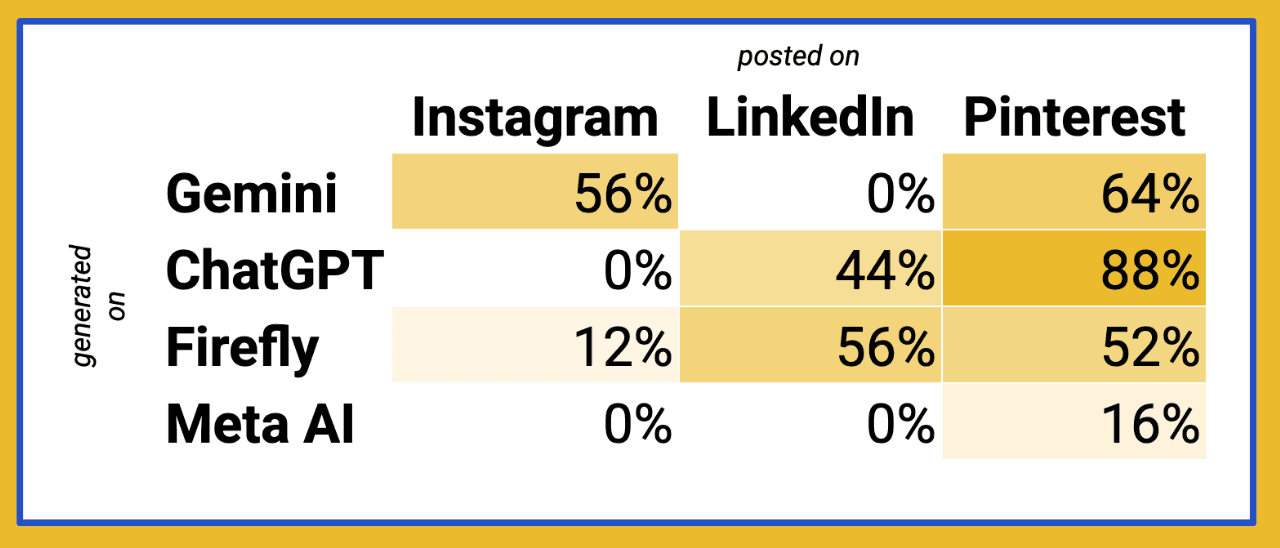

Per generare 100 immagini con l’IA, abbiamo utilizzato Adobe Firefly, ChatGPT, Google Gemini e Meta AI. Per generare 133 video artificiali, invece, abbiamo utilizzato Google Veo (con Gemini e Flow; Google ama avere la stessa funzionalità disponibile in software diversi), Meta AI, Sora 2 e i software di generazione IA interni a TikTok e YouTube.

Abbiamo utilizzato lo strumento “Verify” per controllare ogni immagine e video alla ricerca di credenziali C2PA. Se non veniva restituito alcun risultato, facevamo clic con il tasto destro del mouse sul file in un computer portatile e selezionavamo l’opzione “Ottieni informazioni” per vedere se venivano restituiti altri metadati relativi all’uso di IA.

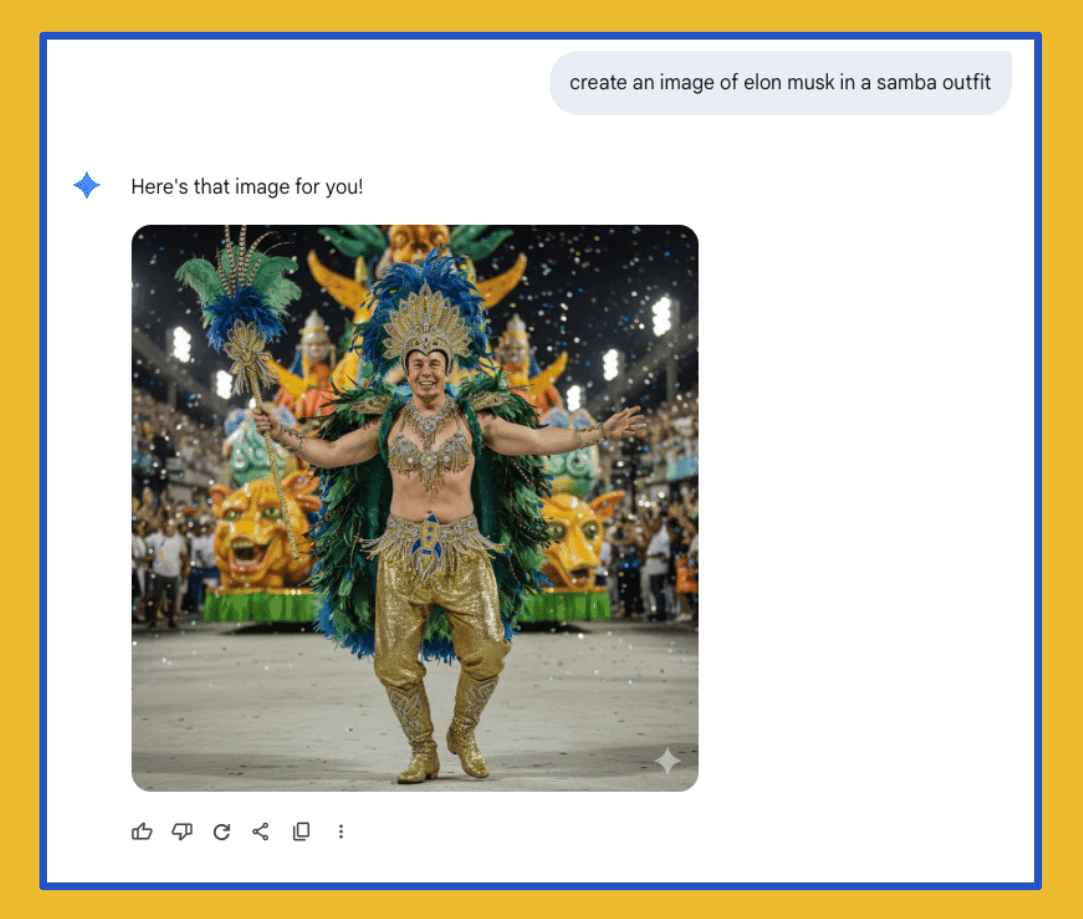

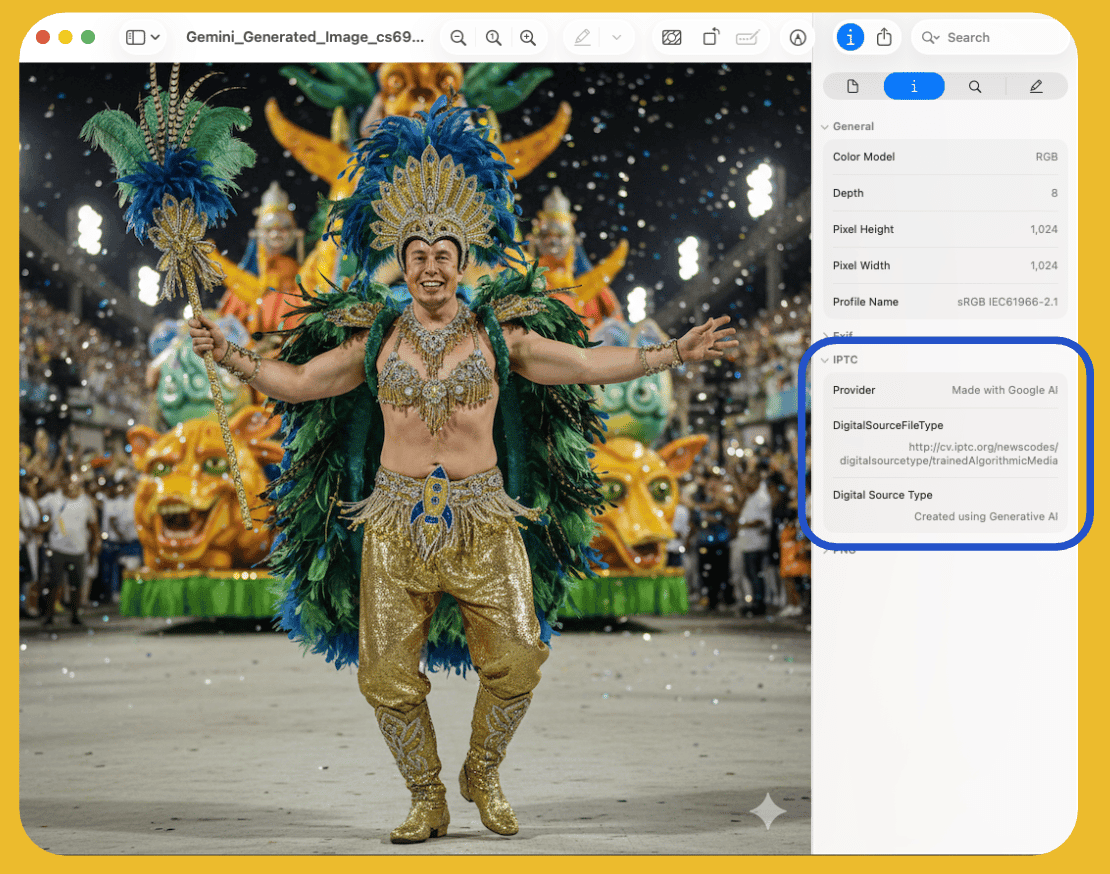

Ad esempio, “Verify” non ha rilevato Content Credentials di tipo C2PA nell’immagine artificiale qui mostrata di Elon Musk che balla la samba. Tuttavia, cliccando con il tasto destro del mouse sull’immagine da un computer portatile, è emerso che essa conteneva un diverso tipo di metadati: secondo lo standard IPTC, infatti, l’immagine era contrassegnata come “Creata utilizzando l’IA generativa”.

A questo punto, però, si poteva già vedere che c’erano alcuni problemi. Non siamo riusciti a rilevare i metadati relativi all’IA per 44 dei 233 elementi generati artificialmente, la maggior parte dei quali era stata generata con Meta AI.

Abbiamo pubblicato i nostri contenuti generati dall’IA su cinque piattaforme principali: le immagini su Instagram, Linkedin e Pinterest; i video su TikTok e YouTube.

Per tenere conto di possibili problemi a livello di dispositivo, abbiamo alternato la pubblicazione dei contenuti da computer portatile, utilizzando un browser, alla pubblicazione da telefono, utilizzando un’applicazione. Dopo il caricamento, abbiamo cercato le etichette IA sui contenuti e nei menu espansi, che le piattaforme hanno dichiarato di poter potenzialmente utilizzare per mostrare tali informazioni. Abbiamo anche ricontrollato tutti i post dopo diversi giorni per verificare se le etichette fossero state applicate con un po’ di ritardo.

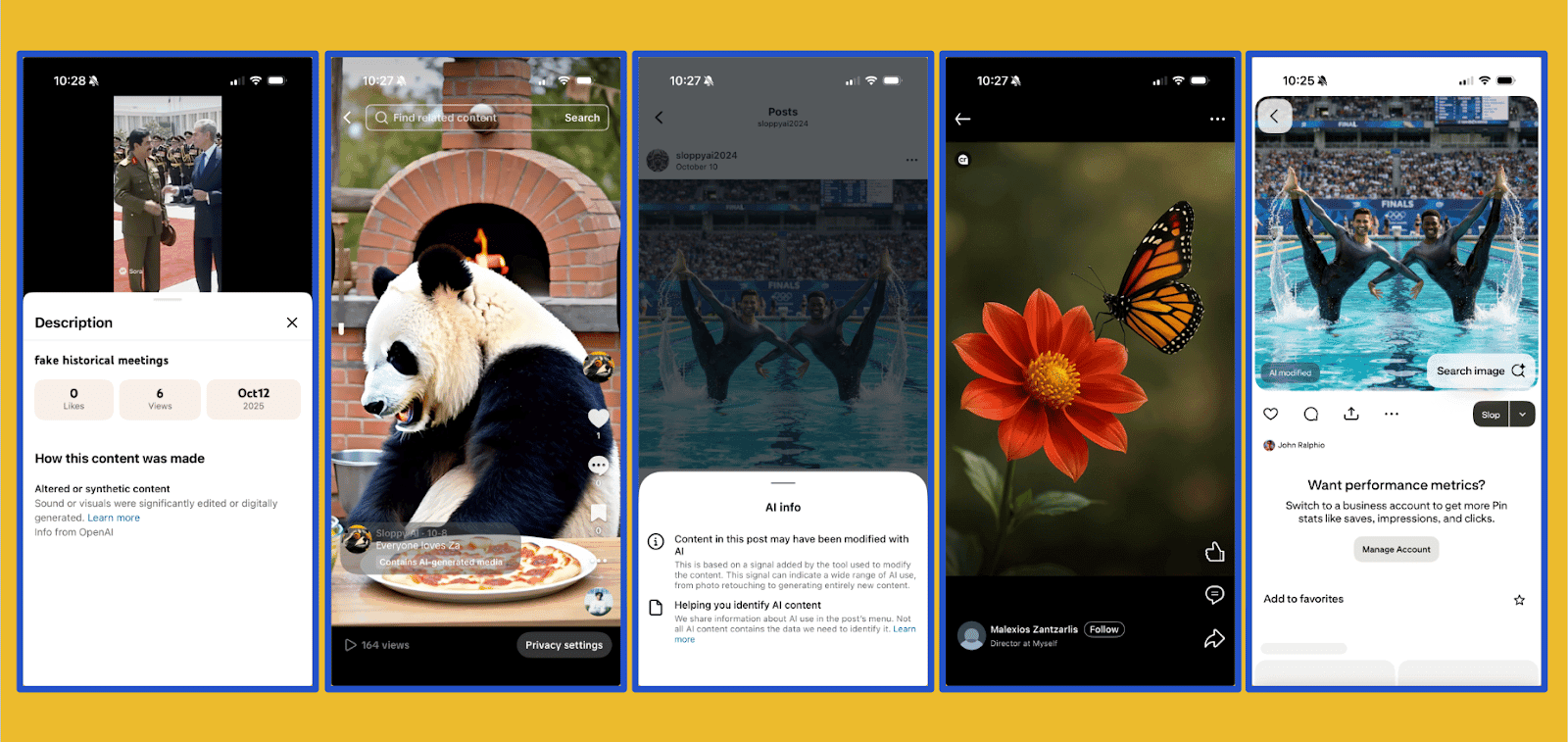

In un’implementazione ideale dell’etichettatura dei contenuti generati con IA, tutti i nostri post avrebbero riportato le etichette mostrate di seguito. Ma questa non è la realtà attuale dell’etichettatura IA.

La cosa più importante da notare è che abbiamo eseguito questi test senza alcuno sforzo antagonistico. In altre parole, non abbiamo cercato di aggirare i meccanismi di etichettatura manomettendo i file.

La ricerca ha dimostrato che alterazioni di base come il ritaglio o la compressione dei file possono influire sui metadati di un file multimediale. Anche se si tratta di operazioni che un utente non ostile potrebbe eseguire quando condivide contenuti generati con IA, abbiamo fatto del nostro meglio per preservare l’integrità delle immagini e dei video durante il loro trasferimento dal modello di IA alle piattaforme social. In questo modo, abbiamo cercato di dare ai sistemi di rilevazione dei social network le migliori possibilità di successo.

I risultati

Nel complesso, solo circa un terzo dei nostri post ha ricevuto un’etichetta IA. Tuttavia, il risultato finale non riflette appieno le sfumature di ciò che le piattaforme hanno promesso di fare, né la significativa variabilità nei tassi di etichettatura delle piattaforme.

Pinterest è stato il migliore nell’etichettare le immagini generate con IA, avendo etichettato correttamente 55 dei 100 post aggiunti. LinkedIn ne ha rilevati 25 e Instagram 17.

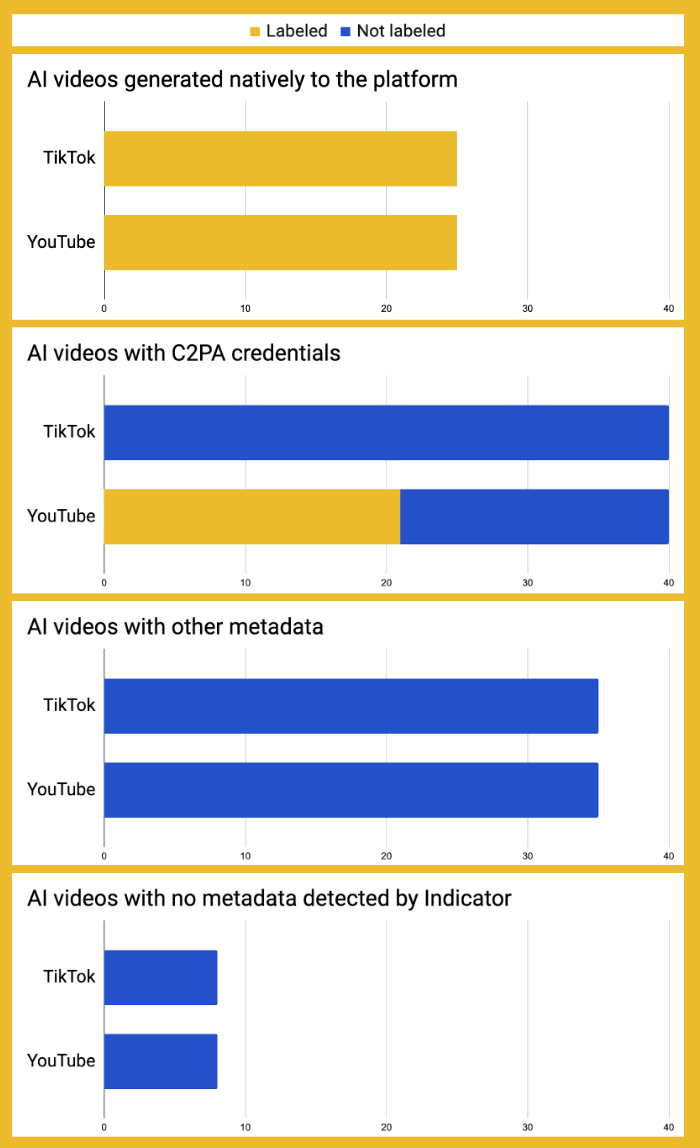

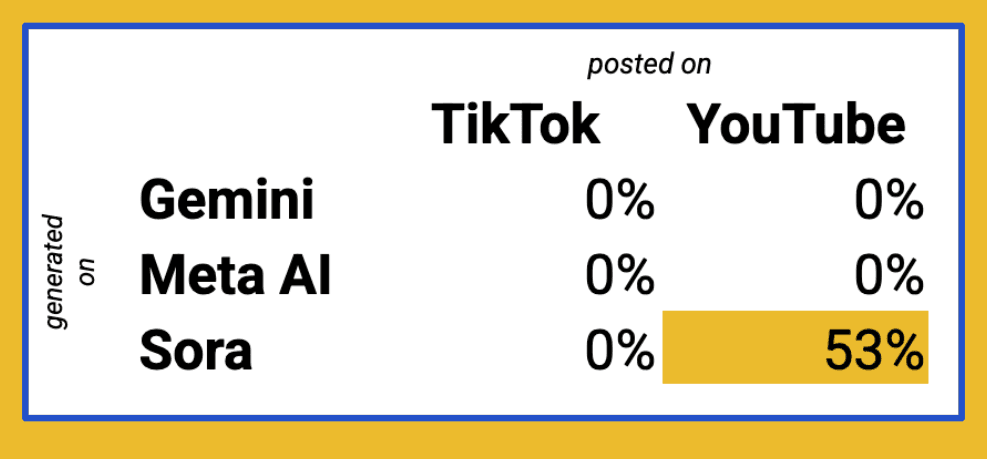

Tra le piattaforme video, YouTube ha ottenuto risultati nettamente migliori rispetto a TikTok; su quest’ultima piattaforma, infatti, non è stato etichettato nemmeno un video generato con IA che non fosse stato creato utilizzando il software IA interno a TikTok stessa. Ad esempio, YouTube ha correttamente etichettato la maggior parte dei nostri video generati con Sora 2, mentre TikTok non ha etichettato alcun contenuto di questo tipo.

Risultati degni di nota

TikTok non è riuscito a etichettare nessuno dei video che abbiamo generato utilizzando i software IA di Google, Meta AI e OpenAI. Questo nonostante l’azienda abbia affermato di aver implementato la «capacità di leggere Content Credentials» più di un anno fa.

Un portavoce di TikTok ha dichiarato a Indicator che la piattaforma sta aggiornando il modo in cui rileva i metadati di tipo C2PA. Questo potrebbe spiegare la mancanza di etichette sui video generati con l’intelligenza artificiale nel nostro campione. TikTok ha anche affermato che, oltre allo standard C2PA, utilizza classificatori che sono stati addestrati per rilevare contenuti realistici generati con l’intelligenza artificiale.

Altrettanto sorprendente è il caso di Meta AI. Nessuna delle 60 immagini e video che abbiamo creato attraverso il suo sito web o la sua app ha restituito Content Credentials quando le abbiamo ispezionate utilizzando “Verify” di C2PA. Le immagini non mostravano metadati nemmeno quando sono state ispezionate su un computer portatile; a questo punto abbiamo chiesto alla società di rilevamento di deepfake GetReal se fosse in grado di rilevarne alcuni con i propri strumenti. Secondo la loro analisi, sono stati trovati metadati IPTC sui video generati con Meta AI, ma non sulle immagini.

Meta non ha risposto alle domande sui suoi software di IA generativa. Un portavoce dell’azienda ha affermato che l’identificazione dei contenuti generati con IA è resa complessa dal rapido sviluppo della tecnologia, e ha sottolineato che l’azienda sta migliorando continuamente i suoi meccanismi di etichettatura.

È possibile che gli aggiornamenti dello standard C2PA rilasciati a maggio e all’inizio di ottobre 2025 spieghino il malfunzionamento dell’etichettatura di Meta e TikTok. Se così fosse, sarebbe un segnale preoccupante della fragilità dell’implementazione delle etichette IA da parte delle piattaforme. Per fare un paragone con la sicurezza informatica, gli aggiornamenti delle piattaforme agli standard di crittografia tendono ad essere retrocompatibili, in modo che le implementazioni precedenti funzionino correttamente.

Dato che i video generati con OpenAI erano etichettati in modo affidabile con lo standard C2PA, questo sembra trattarsi di un problema organizzativo interno a Meta e TikTok, piuttosto che di un problema tecnico con i metadati. Gregory di Witness ha affermato che «standard come il C2PA si basano su principi solidi e sono stati pensati mantenendo il focus su questioni come la privacy e l’accesso, ma sono tecnicamente complessi da implementare su Internet. La domanda è: perché i leader delle aziende tecnologiche non stanno allocando le risorse ingegneristiche e di prodotto necessarie per realizzare questo obiettivo? Lo devono a tutti noi».

Parsons di Adobe ha dichiarato a Indicator che «stiamo assistendo a progressi significativi in tutto il settore nell’adozione delle Content Credentials e siamo incoraggiati dalla collaborazione attiva in corso per rendere più visibile la trasparenza di questi dati online. Ora è fondamentale che un numero maggiore di piattaforme e social media mostrino queste informazioni, in modo che i consumatori possano prendere decisioni informate sui contenuti che vedono».

L’autocertificazione fallisce

Forse la cosa più sorprendente è stato il fatto che Google e Meta non siano riusciti a etichettare i contenuti generati utilizzando i propri software. I video generati con Gemini non sono stati etichettati correttamente su YouTube, e lo stesso vale per le immagini create con Meta AI e pubblicate su Instagram.

Un portavoce di Meta ha dichiarato a Indicator che il rilevamento dell’IA è un compito impegnativo e che l’azienda sta migliorando continuamente i propri meccanismi. Google non ha risposto alle richieste di commento sui watermark dei contenuti generati con Gemini.

Leibowicz, di Partnership on AI, ha dichiarato a Indicator che «avendo guidato gli sforzi per la creazione di un framework per i media generati con IA e avendo lavorato direttamente con le aziende tecnologiche su queste sfide, so che l’etichettatura dell’IA è tecnicamente complessa: questioni come l’interoperabilità tra piattaforme sono davvero difficili. Ma questo non esime le aziende dal reperire risorse, rappresentare accuratamente le loro attuali capacità piuttosto che esagerarle e, da ultimo, mantenere i propri impegni».

Configurazione fragile

Come indicato nella nostra metodologia, abbiamo cercato di evitare di alterare il contenuto generato dall’IA dopo la sua creazione.

Durante l’esperimento, abbiamo notato che il modo in cui abbiamo generato e/o pubblicato i contenuti sembrava influire sul fatto che i metadati viaggiassero o meno insieme al file, e sulla sua successiva etichettatura da parte di una piattaforma.

Un fattore chiave di differenziazione era se il file fosse stato generato su un telefono o su un computer portatile. Le immagini generate con Adobe Firefly su dispositivi mobili e scaricate su un iPhone non riportavano Content Credentials, mentre quelle generate su computer portatile sì. Nella maggior parte dei casi, l’assenza di Content Credentials significava che non venivano etichettate dalle piattaforme. Le immagini create con Gemini e scaricate su un iPhone come file (anziché come foto) non venivano etichettate come generate con l’IA su Instagram.

I video generati con Sora 2 che avevano metadati al momento della pubblicazione non hanno innescato il meccanismo di etichettatura IA su YouTube per dispositivi mobili. Tuttavia, YouTube ha correttamente etichettato i video provenienti dalla stessa fonte quando sono stati caricati tramite un computer portatile.

Henry Ajder, ricercatore nel campo dei deepfake e consulente di diverse organizzazioni attive in questo settore, ha dichiarato a Indicator che «il mosaico di incongruenze relative allo standard (C2PA, ndr) e ad altri approcci all’etichettatura dei contenuti dimostra che c’è ancora molto da fare». Ajder ha aggiunto: «Il fatto che in questa ricerca si fatichi a comprendere i punti in cui la catena si interrompe è un esempio molto eloquente di quanto sia difficile integrare questo aspetto in un processo piuttosto semplice, figuriamoci in uno più sofisticato come la creazione di uno spot pubblicitario o di un video musicale professionale, che coinvolge molti più content creators, molti elementi di composizione e non viene condiviso solo sui social media, ma anche tra testate giornalistiche e in diversi formati».

Stranamente, diverse immagini pubblicate su Pinterest non sono state immediatamente etichettate come generate con l’IA, ma avevano un’etichetta quando abbiamo controllato alcuni giorni dopo.

Un rappresentante di Pinterest ha detto a Indicator che il ritardo è attribuibile a un metodo di elaborazione in batch, che può richiedere un paio di giorni. Stando a quanto detto dall’azienda, Pinterest sta anche lavorando a nuovi strumenti per migliorare il rilevamento delle immagini generate e modificate con l’IA che non dispongono dei metadati pertinenti.

Aspetti positivi

I risultati principali di questo esperimento sono scoraggianti, ma ci sono alcuni aspetti positivi.

Innanzitutto, OpenAI sembra utilizzare un meccanismo solido per taggare le immagini generate con ChatGPT e i video creati con Sora 2. Tutti i contenuti artificiali che abbiamo generato con gli strumenti di OpenAI hanno mostrato le Content Credentials quando sono stati testati con lo strumento “Verify” di C2PA. Ciò significa anche che era più probabile che venissero etichettati dalle piattaforme social su cui li abbiamo pubblicati.

Anche alcuni percorsi specifici sembravano funzionare correttamente. Tutte le immagini generate con Adobe Firefly e pubblicate da un computer portatile su LinkedIn sono state etichettate correttamente. Lo stesso vale per le immagini generate con Gemini e pubblicate da un telefono su Instagram, e per i video generati con Sora 2 e pubblicati da un computer portatile su YouTube.

L’affidamento di Pinterest sui classificatori oltre che sui metadati sembra aver aiutato l’azienda a raggiungere un tasso di rilevamento più elevato rispetto alle altre, anche se il 55 per cento è un risultato ancora piuttosto basso. A causa della metodologia di questa analisi, non siamo in grado di stabilire se l’approccio di Pinterest stia etichettando in modo errato anche contenuti non IA come artificiali.

Cosa deve succedere ora

Generare e pubblicare contenuti di scarsa qualità con frequenza è stato un esperimento nauseante. È stato davvero sconcertante quando alcuni dei nostri contenuti hanno ricevuto migliaia di visualizzazioni (tutti i video saranno eliminati entro la fine del mese, una volta che le piattaforme avranno avuto tempo sufficiente per verificare cosa possa essere andato storto).

A parte il mal di stomaco causato da simili contenuti, la nostra analisi dimostra che sono necessari controlli regolari per garantire che le piattaforme mantengano le loro promesse. Le regolamentazioni a livello statale (in California) e sovranazionale (in Unione europea) dovrebbero garantire, entro l’estate del 2026, un numero molto maggiore di etichette relative ai contenuti generati con IA, applicate su tutte le piattaforme. Ma non possiamo dare per scontato che ciò accadrà.

L’etichettatura dei contenuti generati con IA non è una panacea. La fragilità evidenziata dai nostri test, infatti, può essere sfruttata dai malintenzionati. «Se fossi il cattivo, mi basterebbe strappare facilmente i metadati e aggirare completamente il sistema», ha detto Farid di GetReal a Indicator.

Anche quando le etichette sono applicate correttamente, possono avere conseguenze indesiderate. Ricerche recenti suggeriscono che gli utenti considerano i contenuti con un’etichetta IA meno credibili, indipendentemente dalla loro veridicità. La ricercatrice Wardle, della Cornell University, ha affermato che questo problema è aggravato da un’etichettatura imprecisa e incompleta.

Tuttavia, sia le etichette sia i metadati che le rendono possibili sono solo il punto di partenza quando si tratta di generare e diffondere in modo responsabile contenuti creati con l’IA. Al momento, però, il settore non è in grado di soddisfare questo requisito. L’incapacità diffusa di etichettare correttamente i contenuti generati con IA suggerisce che le principali piattaforme potrebbero non essere all’altezza della sfida per contrastare l’uso improprio degli strumenti di IA generativa.

Parsons di Adobe afferma che l’Iniziativa per l’autenticità dei contenuti (CAI) è «concentrata sul ridurre il divario tra il rapido ritmo dell’innovazione dell’IA generativa e la continua introduzione delle Content Credentials come soluzione affidabile per la trasparenza e la provenienza dei contenuti digitali. La coerenza e l’interoperabilità sono essenziali per la fiducia, motivo per cui la C2PA ha recentemente lanciato un Conformance Program (“programma di conformità” in italiano, ndr) per garantire un’implementazione affidabile e standardizzata su tutte le piattaforme».

Molti degli esperti con cui abbiamo parlato hanno affermato che gli sforzi relativi alla provenienza dei contenuti sono fondamentali tanto quanto le etichette. In questo senso, Gregory di Witness ha affermato che «con la diffusione dell’IA iperrealistica, è essenziale garantire il prima possibile la trasparenza sull’uso dell’IA, per consentire la creatività, l’allegoria e la satira, ma anche per distinguere la realtà dalla falsità».

Ajder ha dichiarato a Indicator che «non si tratta solo di combattere la disinformazione, ma di fornire un’infrastruttura di fiducia completamente nuova per l’era artificiale».

- La destra polacca vuole uscire dall’Unione europea usando giovani donne create con l’IA

La destra polacca vuole uscire dall’Unione europea usando giovani donne create con l’IA

La destra polacca vuole uscire dall’Unione europea usando giovani donne create con l’IA - Questo video di un robot che taglia i capelli in strada a Dubai non è realeQuesto video di un robot che taglia i capelli in strada a Dubai non è reale