Per la prima volta nella storia entrambe le fazioni impiegate in un conflitto stanno facendo largo uso di disinformazione generata dall’IA per motivi di propaganda

Il 13 giugno 2025, Israele ha attaccato l’Iran in una serie di raid coordinati, colpendo decine di installazioni nucleari, basi militari e infrastrutture missilistiche, ma anche alcune zone residenziali della capitale Teheran. Il primo ministro israeliano Benjamin Netanyahu ha dichiarato che l’operazione “Rising Lion” ha colpito «il cuore del programma nucleare iraniano», che secondo lui potrebbe presto produrre un’arma in grado di mettere a repentaglio l’esistenza stessa di Israele.

La Guida Suprema dell’Iran, l’ayatollah Ali Khamenei, aveva fin da subito minacciato una punizione severa in risposta agli eventi, che non si è fatta attendere: poche ore dopo l’attacco, l’Iran ha dato il via un’operazione chiamata “True Promise 3”, attuata con missili balistici su basi e obiettivi militari in Israele. L’esercito israeliano dice di averne intercettati la maggior parte con il sistema Iron Dome.

Quello che sembrava l’ennesimo conflitto regionale ha fatto un salto di qualità nella giornata del 21 giugno, quando il presidente degli Stati Uniti Donald Trump ha ordinato un attacco aereo a tre principali impianti di arricchimento nucleare iraniani – Fordow, Natanz e Isfahan – che secondo fonti del Pentagono sarebbero stati condotti utilizzando anche bombe “bunker buster”, ovvero in grado di penetrare e colpire gli obiettivi in profondità. Trump ha descritto l’operazione come «uno spettacolare successo militare» e ha aggiunto che le strutture sono state «completamente distrutte», mentre l’Iran ha parlato di danni limitati. Non è comunque ancora ben chiaro se l’operazione abbia o meno pregiudicato la capacità iraniana di arricchire l’uranio e produrre armi nucleari.

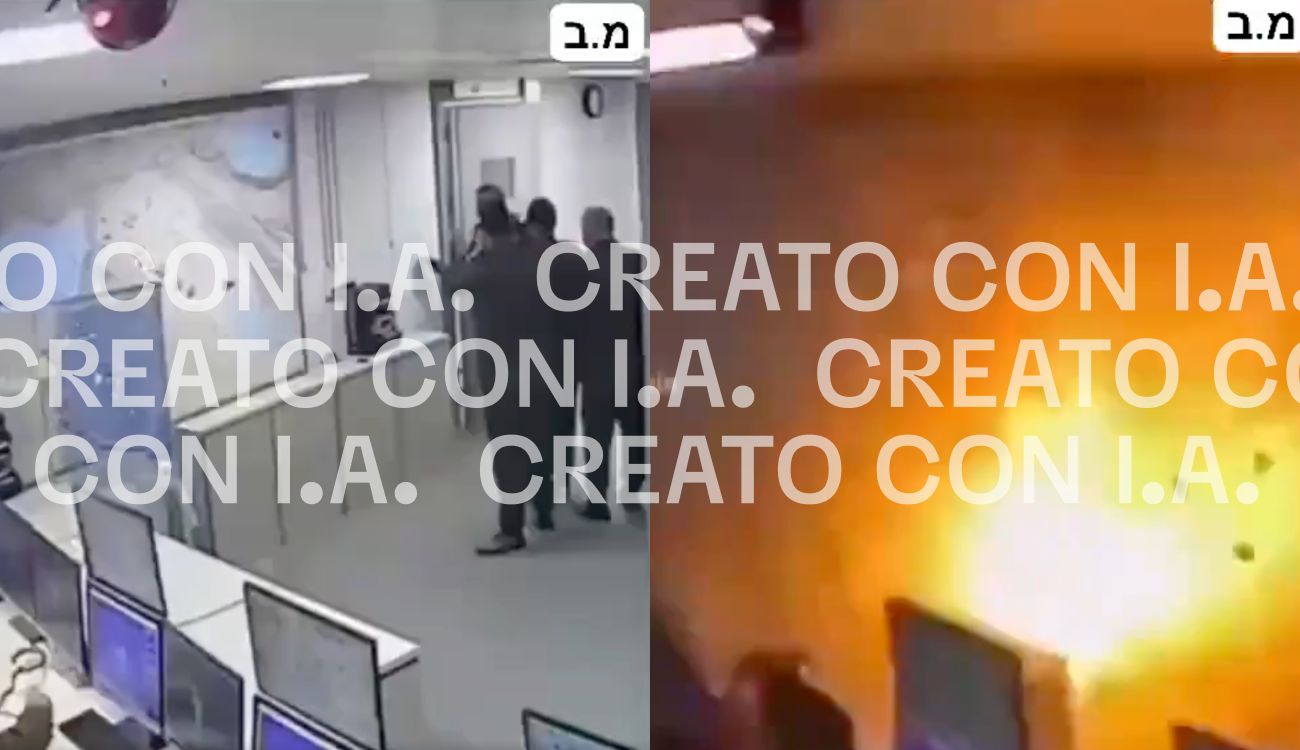

Mentre lo scontro tra Israele e Iran si intensifica rapidamente, i social sono stati invasi da contenuti di intelligenza artificiale pubblicati da esponenti di entrambe le fazioni impegnate nel conflitto. Una vera e propria operazione di propaganda speculare, che rende quello tra Israele e Iran il primo conflitto completamente dominato dall’intelligenza artificiale come strumento di guerra informativa.

La guerra parallela si combatte sui social media

Gli scenari di conflitto sono da sempre i più sensibili alla disinformazione, online e non, ma l’arrivo dell’intelligenza artificiale generativa ha segnato un netto salto di qualità in tal senso. Da un lato, i contenuti creati con l’IA riempiono il vuoto lasciato dalla censura imposta dai governi e dalle comprensibili difficoltà logistiche dei giornalisti in scenari di guerra, diffondendo disinformazione. Dall’altro, i leader stessi dei Paesi coinvolti nell’escalation condividono la cosiddetta “spazzatura” generata dall’IA per alimentare vecchi meccanismi di propaganda e xenofobia.

Qualche giorno fa, ad esempio, alcuni media iraniani hanno riportato che l’esercito avrebbe abbattuto tre caccia F-35 israeliani. Israele ha subito smentito, ma intanto la notizia ha iniziato a circolare — e con lei anche le presunte immagini dei jet caduti. In una di queste foto si vede un gigantesco F-35 fumante a terra, vicino a una cittadina. La cabina di pilotaggio è talmente grande che fa sembrare minuscole le case intorno, mentre alcune persone sembrano muoversi accanto al relitto. Una scena talmente surreale da essere, infatti, completamente falsa. Un’altra immagine mostrava il jet schiantatosi in un campo, di notte, con le ali distrutte e il postbruciatore, cioè un impianto utilizzato su alcuni motori aeronautici a reazione, ancora incandescente. Anche quella era del tutto falsa.

Ma non sono solo anonimi propagandisti — dilettanti o professionisti — a diffondere contenuti generati con l’intelligenza artificiale. Lo stanno facendo anche i leader di Iran e Israele. Il leader supremo iraniano, l’ayatollah Ali Khamenei, ha pubblicato sul suo profilo X alcune immagini generate con l’intelligenza artificiale che mostrano il lancio di alcuni missili, e scene simili, grottesche quanto surreali, si trovano anche sull’account del ministro della Difesa israeliano.

Iran is like an egg: hard on the outside and soft on the inside.

— ישראל כ”ץ Israel Katz (@Israel_katz) September 26, 2024

Most of the public is against the regime, and the economy is in a difficult state. Global sanctions and damage to key energy and economic sectors will severely harm the Ayatollahs' regime.@khamenei_ir pic.twitter.com/IlvUjqFDov

A peggiorare la situazione c’è il rapido miglioramento dei software di intelligenza artificiale generativa e tra tutti spicca Google Veo 3, in grado di dare vita a filmati quanto mai realistici. Ad esempio, il Tehran Times ha condiviso su X un filmato che, a sentire loro, mostrava «il momento in cui un missile iraniano colpiva un edificio a Bat Yam, nel sud di Tel Aviv». Era un falso. In un altro video, che sembrava preso da un telegiornale, si vede invece un enorme missile muoversi in un lungo corridoio di cemento. Anche quello era stato creato con l’intelligenza artificiale — e si vede chiaramente il watermark in basso a destra con scritto Veo.

Dopo l’attacco lanciato dall’Iran contro Israele, il Tehran Times ha poi diffuso un filmato presentato come “l’Apocalisse a Tel Aviv”. Le immagini — riprese da un drone — ruotavano su edifici distrutti e cumuli di macerie, in uno scenario da fine del mondo. Ma, come ormai avrete intuito, anche questo video era un falso generato con l’intelligenza artificiale. È comparso sia su Telegram che su TikTok, su un account chiamato 3amelyonn (ora non più attivo).

Come racconta un approfondimento della testata online 404media, il canale TikTok in lingua araba 3amelyonn si definiva come parte di una “Resistenza dell’Intelligenza Artificiale” — un nome che suggerisce l’intenzione di usare l’IA come strumento di lotta o propaganda, probabilmente a sostegno della causa iraniana o anti-israeliana.

L’intelligenza artificiale e il fact-checking

Un caso di disinformazione molto particolare riguarda il video che mostra una lunga fila di camion che portano dei missili fuori da una grotta. Il filmato è stato chiaramente creato con l’intelligenza artificiale, come si intuisce da alcune imperfezioni grafiche, ma quando Grok – il chatbot di X – è stato interrogato sulla veridicità del filmato, non ha mai avuto dubbi: era tutto vero. E anzi, Grok ha ripetutamente insistito che il filmato fosse stato pubblicato da testate giornalistiche come Newsweek e Reuters. Tutto falso.

In questi giorni di escalation militare e di contenuti non verificati, Grok è stato spesso interpellato in veste di “fact-checker” e i suoi giudizi sono stati quasi sempre sbagliati, come sottolineano i colleghi di BBC Verify (come avevamo spiegato in questo approfondimento, i chatbot IA non sono affatto affidabili come strumenti di fact-checking). Il problema è chiaramente amplificato dal fatto che, come riportano ancora i colleghi di BBC Verify e come emerge dall’esperienza diretta della redazione di Facta, la maggior parte dei contenuti di disinformazione citati è stata pubblicata su X.

Guerra e propaganda

La diffusione di media generati dall’intelligenza artificiale in questo conflitto è particolarmente intensa proprio perché sia Iran che Israele chiedono ai propri cittadini di non condividere immagini o video di distruzione. Questo per evitare di aiutare il nemico a migliorare il proprio sistema di attacco, studiando le posizioni colpite.

Per esempio, il 14 giugno alcuni account istituzionali israeliani hanno chiesto esplicitamente: «Non pubblicate e non condividete la posizione o i video degli attacchi. Il nemico usa queste informazioni per affinare i suoi obiettivi. Siate responsabili: non diffondete le coordinate sul web!». Ma quando c’è questo vuoto di informazioni ufficiali o immagini reali, sui social spuntano video e foto falsi creati con l’intelligenza artificiale, che vanno a riempire quel silenzio.

Una cosa che salta subito all’occhio nei video che circolano sui social in queste ore, spesso dei falsi creati con l’intelligenza artificiale, è che la distruzione si vede solo sugli edifici. Non c’è traccia di persone o sangue nelle riprese aeree, probabilmente perché immagini che mostrano corpi umani o feriti vengono bloccate più facilmente sia dai software che generano queste immagini sia dalle piattaforme social dove i video vengono condivisi. Quando compaiono delle persone, sono quasi sempre solo spettatori — come nella foto del presunto F-35 abbattuto. È molto raro vedere scene di combattimenti reali o feriti.

Eppure basterebbe guardarsi attorno, perché il materiale reale e sconvolgente che arriva dal Medio Oriente non manca affatto, purtroppo. È che la realtà, spesso, sfugge ai tentativi di essere incasellata nelle narrazioni propagandistiche e così i filmati creati con l’IA sono giudicati più spendibili dalla comunicazione di guerra. Perché nell’IA non c’è violenza reale, non c’è vero conflitto. C’è solo la comoda finzione di una distruzione senza morti, senza vinti né vincitori. Una bugia, certo, ma una bugia di gran lunga più gradevole della verità.